DOI del artículo: https://doi.org/10.22201/dgtic.26832968e.2022.7.3

Resumen • Introducción • Desarrollo • Resultados • Conclusiones • Bibliografía • [Versión PDF]

3/5

La cantidad de imágenes para el entrenamiento difiere en cada uno de los dos modelos de redes neuronales convolucionales debido a que se buscó tener un número de datos balanceado para las tres clases, tanto para la red neuronal convolucional en cascada (modelo 1), como para el multiclase (modelo 2).

Para el conjunto de pruebas, las imágenes de la clase COVID-19 provienen de la base de datos del Hospital Universitario San Cecilio, la Facultad de Medicina de la Universidad de Montreal, la Universidad de Qatar y la Universidad de Dhaka. La clase neumonía se obtuvo del conjunto de datos de la Universidad California San Diego y de RSNA. La clase sano proviene de la base de datos de la Universidad California San Diego, de RSNA y de NIH.

El modelo 1 pertenece a la red en cascada, y en su primera etapa detecta entre imágenes pertenecientes a pacientes sanos y enfermo. En el caso de enfermos, estas imágenes pasan a una segunda etapa, en la cual otra red clasifica entre neumonía y COVID-19. Se muestran índices de medición cuantitativa en cada fase mencionada de manera individual, y después índices en todo el flujo para verificar su funcionamiento total. El modelo 2 corresponde a la red neuronal convolucional multiclase capaz de seleccionar las tres clases, de igual manera aquí se muestran mediciones cuantitativas para evaluar su desempeño.

Se presentan los resultados de las redes neuronales convolucionales con salidas binarias. Primero la ResNet detecta sano y enfermo, después la ResNet detecta neumonía y COVID-19. Se muestran los resultados individualmente y en conjunto para comprobar cómo funcionan ambos modelos. Por último, se agrega información de la red neuronal convolucional multiclase capaz de seleccionar las tres clases.

La ResNet 152 encargada de detectar sano y enfermo procesando 1,667 imágenes para la validación. Como parte de las métricas se generó una matriz de confusión para analizar los resultados, obteniéndose 97% de exactitud durante el entrenamiento. La figura 6 muestra las mediciones sobre los datos de validación.

Figura 6. Matriz de confusión para datos de validación en el modelo 1,

Primera etapa. Clasifica entre Sano y Enfermo. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

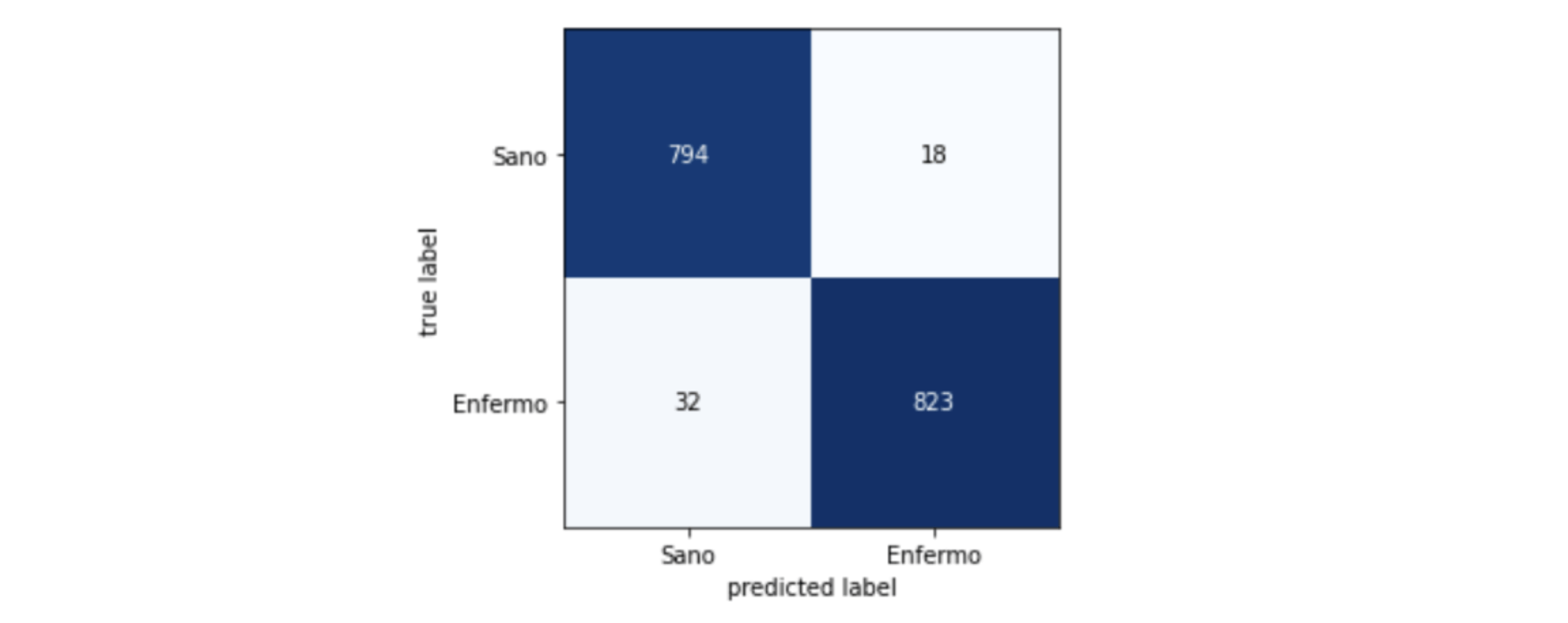

Las métricas de precisión, exhaustividad y valor F1 se ejecutaron para calcular la eficiencia de cada clase del modelo, teniendo una exactitud de 91.792%. En la figura 7 se despliegan los resultados obtenidos del conjunto de prueba y la tabla 1 muestra los resultados de las mediciones.

Figura 7. Matriz de confusión con datos de prueba, para la prueba Sano y Enfermo. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

Tabla 1. Resultados de la prueba en pacientes: Sano y Enfermo. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

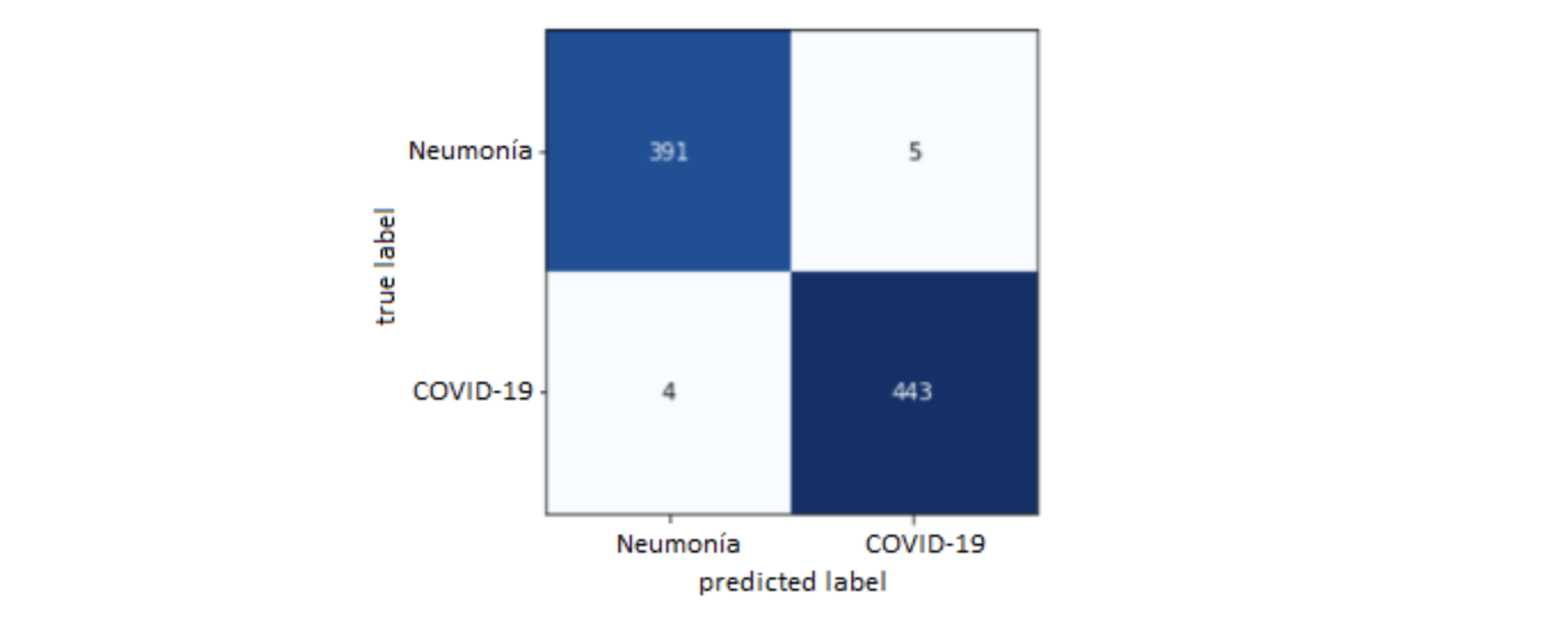

En la segunda etapa del modelo 1, la red neural convolucional ocupada para la detección de neumonía y COVID-19 tuvo un conjunto de validación de 843 imágenes que se probaron en el modelo para medir sus resultados y tuvo una exactitud de 98.92% durante el entrenamiento. La figura 8 muestra la matriz de confusión obtenida.

Figura 8. Matriz de confusión para datos de validación: Neumonía y COVID-19. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

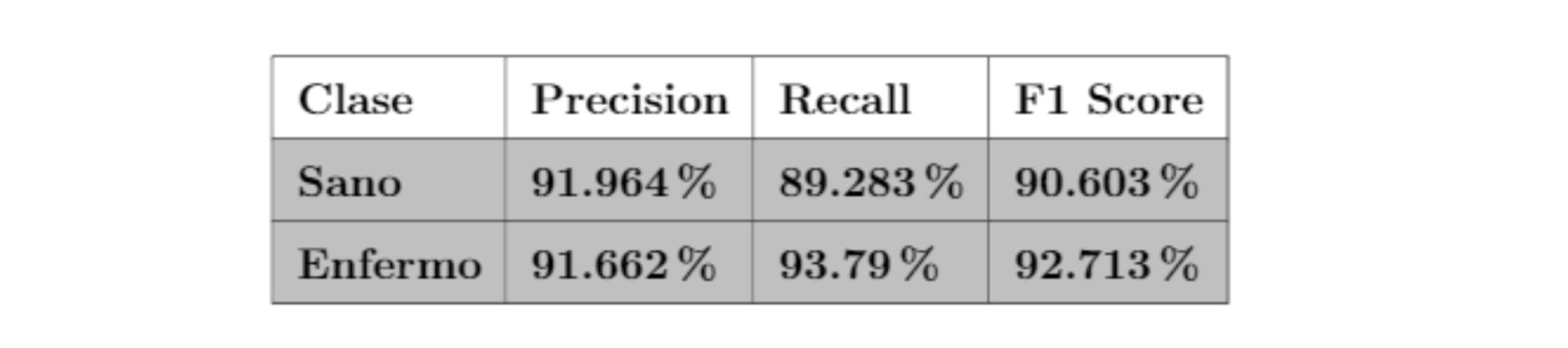

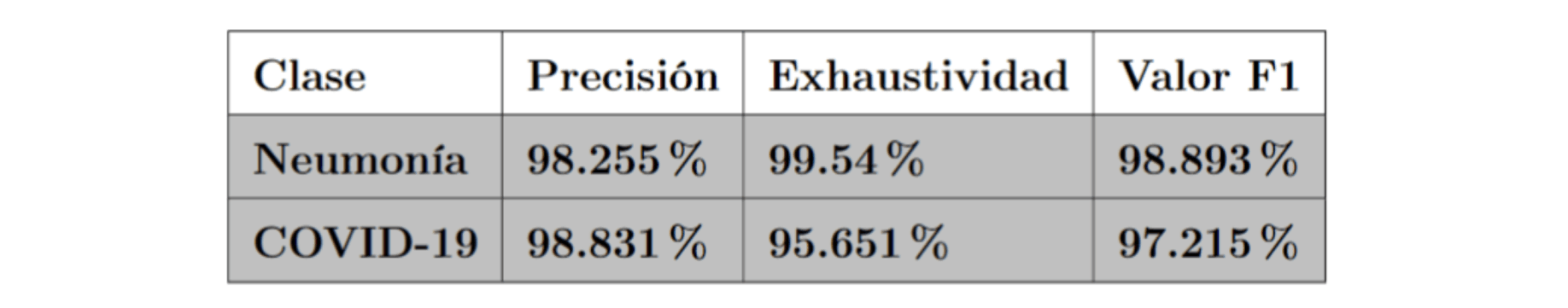

De igual manera, se observaron las métricas de exhaustividad, precisión y valor F1 para analizar la ResNet 152, se emplearon las imágenes que pertenecen a dichas clases y la exactitud de esta segunda etapa fue de 98.42%. En la figura 9 y tabla 2 se muestran los resultados obtenidos del conjunto de prueba.

Figura 9. Matriz de confusión para datos de prueba: Neumonía y COVID-19. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

Tabla 2. Resultados de la prueba Neumonía y COVID-19. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

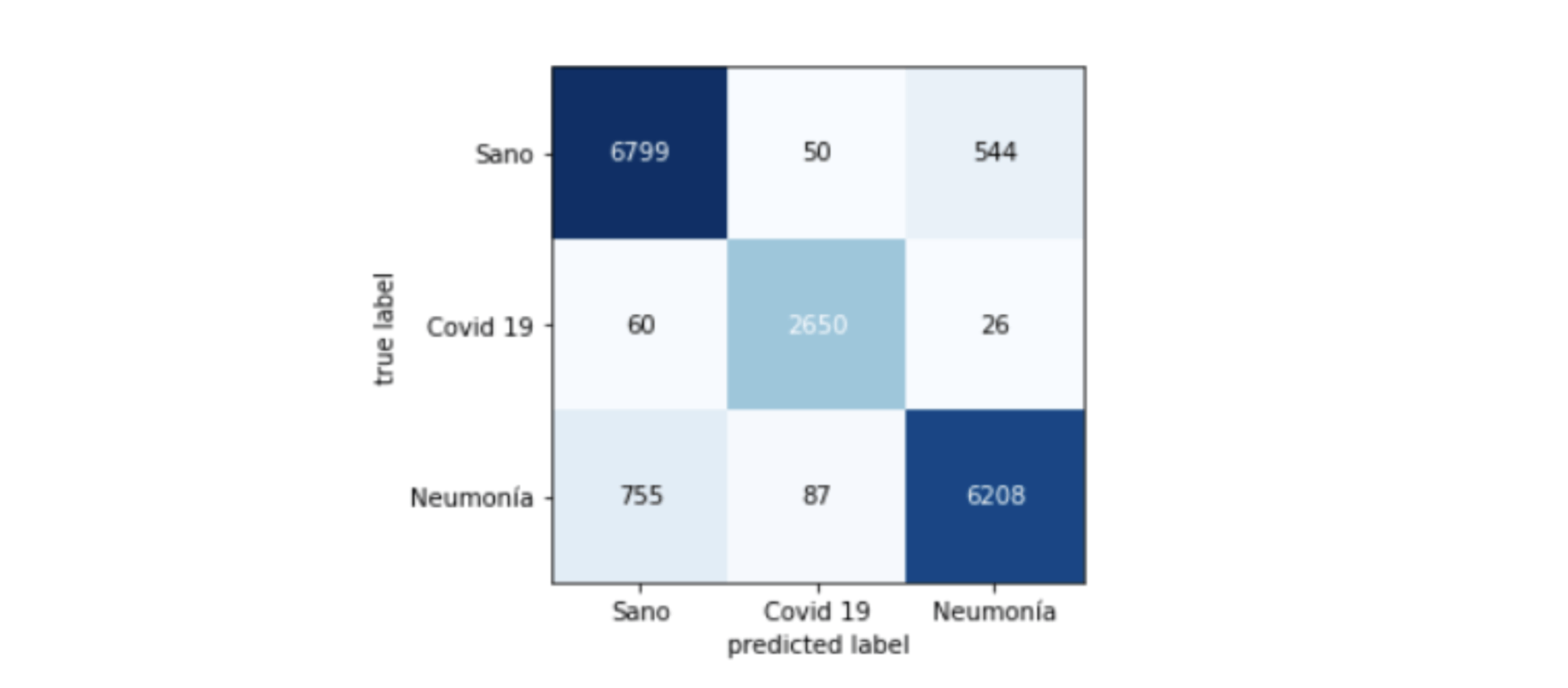

El conjunto de pruebas abarcó 17,179 imágenes para probar el flujo completo del modelo 1 en cascada, pasando por la primera etapa: sano o enfermo y en caso de ser enfermo se va a la segunda etapa donde indica si es COVID-19 o neumonía. A continuación, se muestra la matriz de confusión para cada clase. Como sucedió en los casos independientes, en la prueba completa se registraron las métricas de precisión, exhaustividad y valor F1, donde la exactitud del modelo fue de 91.14%. La figura 10 y tabla 3 muestran los resultados obtenidos del conjunto de prueba.

Figura 10. Matriz de confusión para la prueba de redes en cascada. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

Tabla 3. Resultados para la prueba de redes en cascada. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

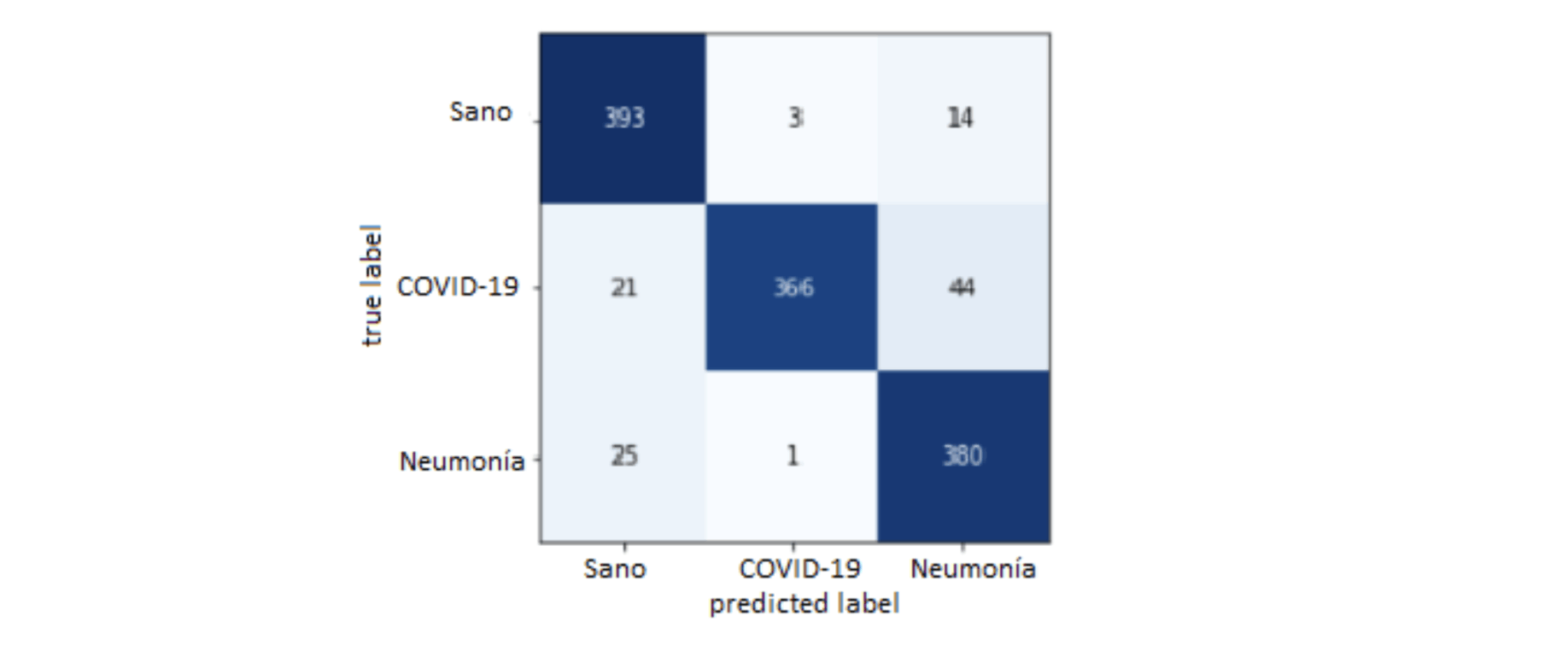

El modelo multiclase utiliza una sola ResNet 152, y el conjunto de validación contó con 1,247 imágenes provenientes de las tres clases. La figura 11 muestra la matriz de confusión resultante.

Figura 11. Matriz de confusión para la validación multiclase. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

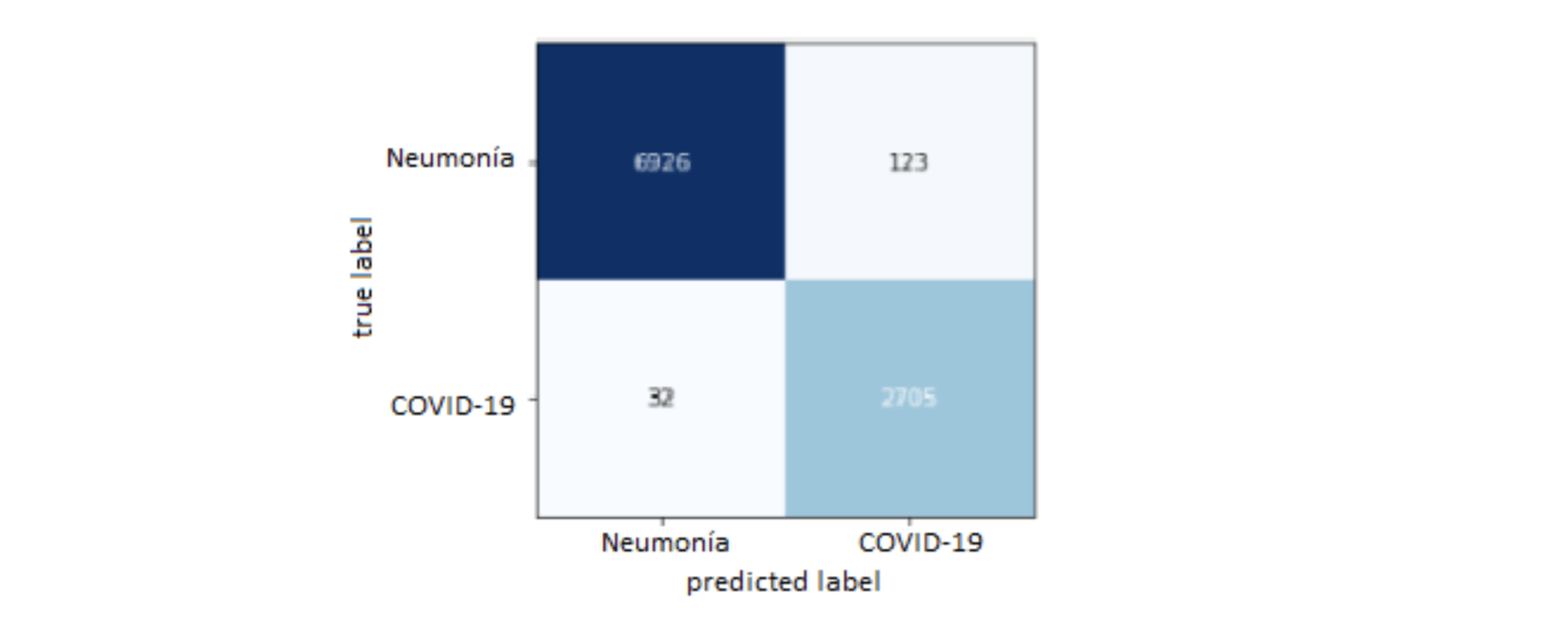

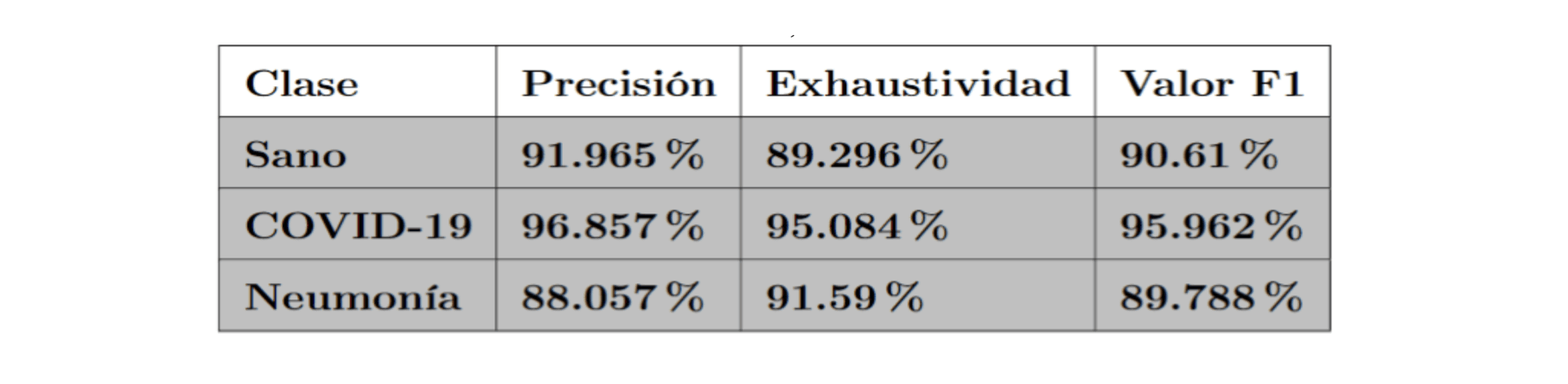

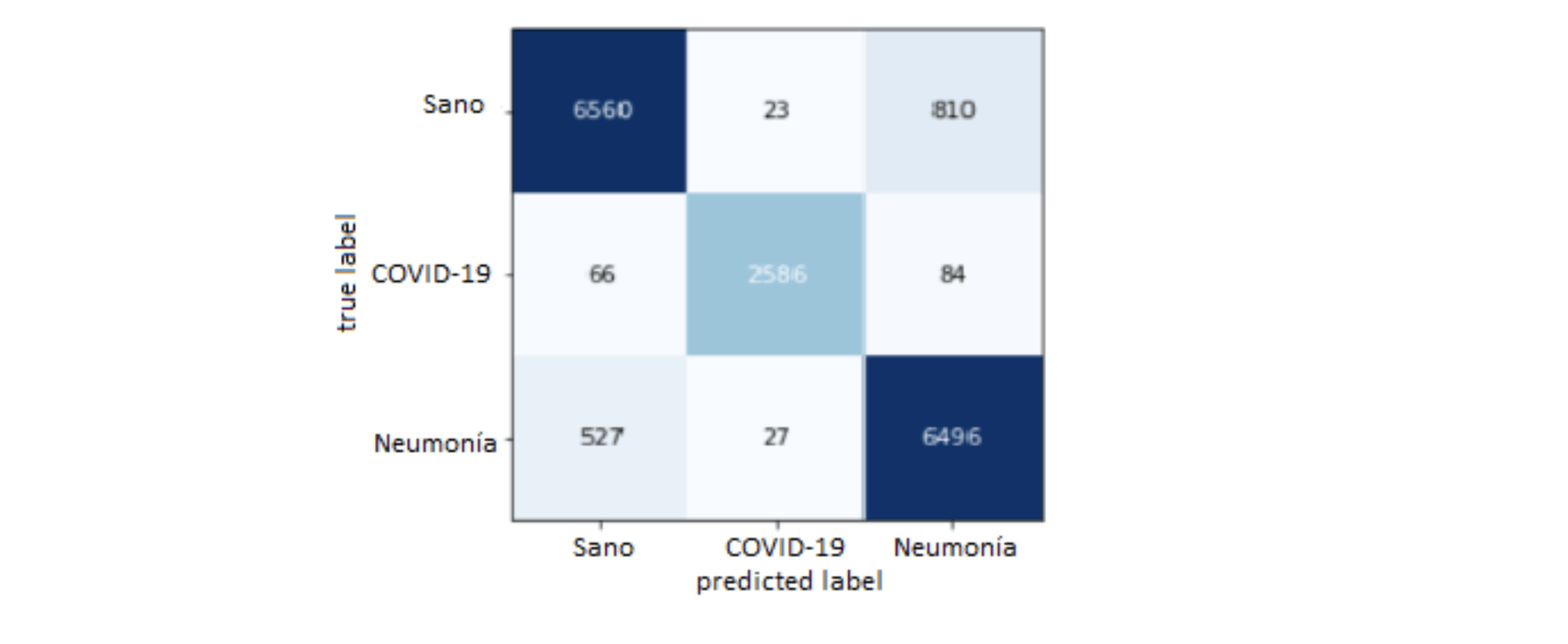

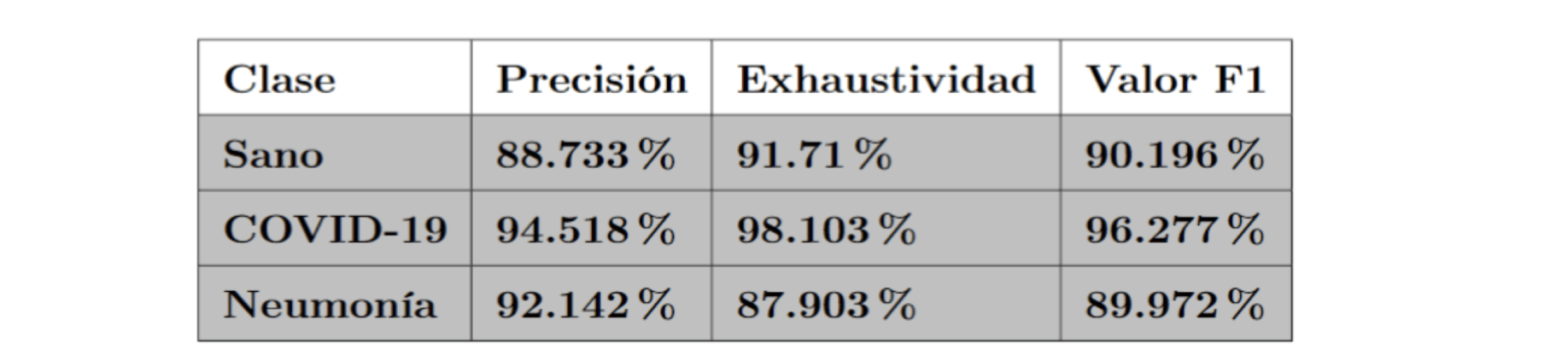

Se realizó el mismo proceso con la red tomando 17,179 imágenes para pruebas y obteniendo métricas de funcionamiento. Se obtuvo la matriz de confusión correspondiente, la cual se puede ver en la figura 12, y en la tabla 4 se muestran los resultados de las métricas de precisión, exhaustividad y valor F1. Este modelo tuvo 91.05% de exactitud.

Figura 12. Matriz de confusión para la prueba multiclase. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

Tabla 4. Resultados para la prueba multiclase. Proyecto Análisis de imágenes médicas para la detección y el seguimiento de COVID-19 UNAM, 2022. Fuente: elaboración propia.

Fecha de recepción: 23 de noviembre de 2021

Fecha de publicación: marzo de 2023

Resumen • Introducción • Desarrollo • Resultados • Conclusiones • Bibliografía • [Versión PDF]